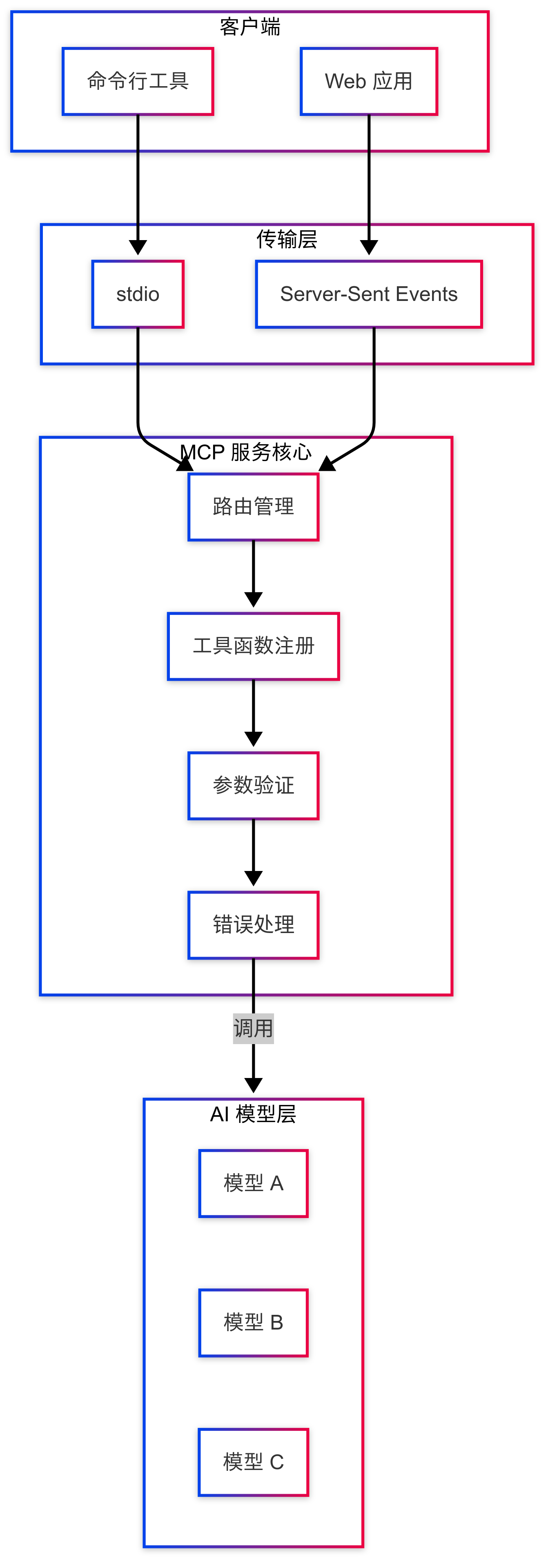

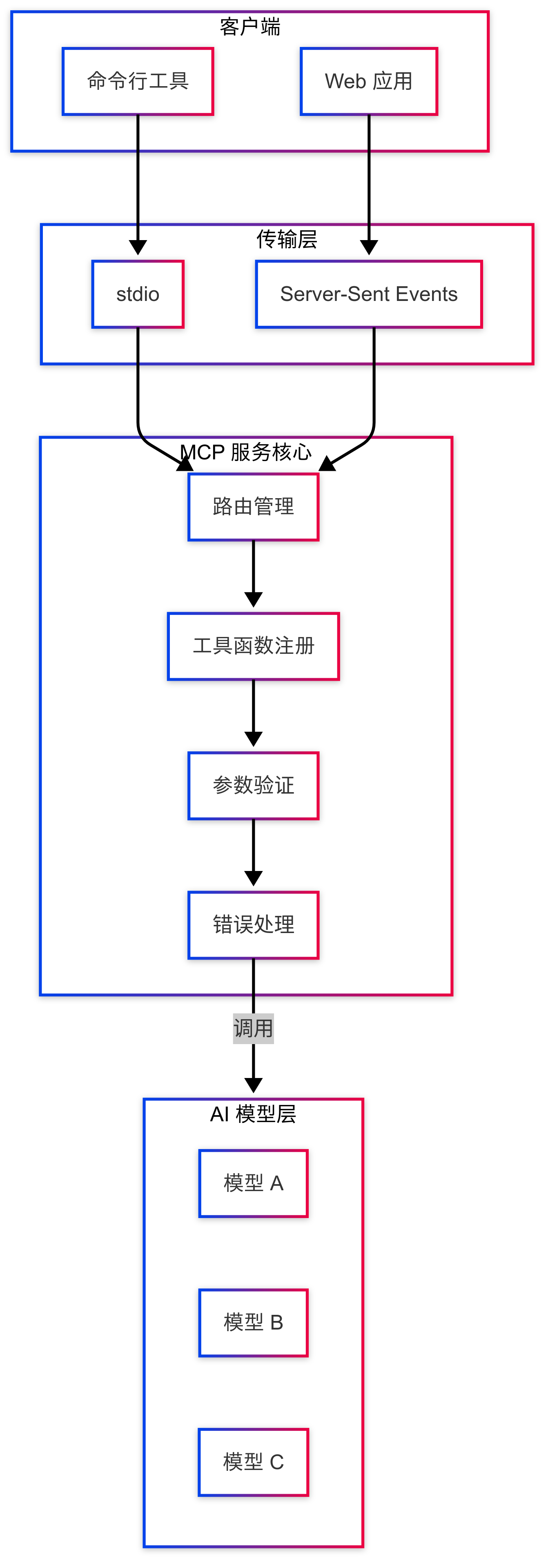

本文介绍如何构建 Model Context Protocol (MCP) 服务,一个用于统一管理和调用 AI 模型的标准化解决方案。从技术选型到最佳实践,为开发者提供完整的 MCP 服务实现指南。

引言

随着 AI 技术的快速发展,如何高效地管理和调用各种 AI 模型成为了一个重要议题。Model Context Protocol (MCP) 服务提供了一个标准化的解决方案,它允许我们以统一的方式与不同的 AI 模型进行交互。在这篇文章中,我将结合实际项目经验,分享如何构建一个专业的 MCP 服务。

什么是 MCP 服务?

MCP(Model Context Protocol)是一个专门为 AI 模型交互设计的协议服务,它具有以下特点:

- 标准化的模型调用接口

- 灵活的传输协议支持(stdio、SSE)

- 异步通信能力

- 强大的工具函数扩展机制

技术栈选择

- 核心框架:FastMCP

- 开发语言:Python 3.x

- 通信协议:stdio/SSE (Server-Sent Events)

- 异步支持:asyncio

- 部署方式:直接运行/容器化

核心功能实现

1. MCP 服务初始化

1

2

3

4

5

6

| from mcp.server.fastmcp import FastMCP

from mcp.server import Server

from mcp.server.sse import SseServerTransport

mcp = FastMCP("your_ai_service")

|

2. 工具函数注册

MCP 服务的核心是通过装饰器注册工具函数,每个工具函数代表一个 AI 模型的能力:

1

2

3

4

5

6

7

8

9

| @mcp.tool()

async def process_ai_request(input_text: str, user_context: str) -> str:

"""处理 AI 请求的工具函数"""

try:

result = await handle_ai_request(input_text, user_context)

return result

except Exception as e:

return f"错误:{str(e)}"

|

3. 传输协议配置

MCP 服务支持多种传输协议,可以根据使用场景灵活选择:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

|

if stdio_mode:

mcp.run(transport='stdio')

else:

from starlette.applications import Starlette

from starlette.routing import Mount, Route

sse = SseServerTransport("/messages/")

async def handle_sse(request):

async with sse.connect_sse(

request.scope,

request.receive,

request._send

) as (read_stream, write_stream):

await mcp_server.run(

read_stream,

write_stream,

mcp_server.create_initialization_options()

)

app = Starlette(

routes=[

Route("/sse", endpoint=handle_sse),

Mount("/messages/", app=sse.handle_post_message),

]

)

|

4. 参数验证和错误处理

为了确保服务的稳定性,需要实现完善的参数验证和错误处理机制:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

| class AIRequestModel:

"""AI 请求参数模型"""

def __init__(self, **kwargs):

self.params = kwargs

self.validate()

def validate(self) -> bool:

"""验证参数有效性"""

required_fields = ['input_text', 'model_type', 'user_context']

return all(field in self.params for field in required_fields)

def handle_error(error: Exception) -> str:

"""统一的错误处理"""

error_type = type(error).__name__

return {

'ValueError': '参数错误',

'RuntimeError': '运行时错误',

'ConnectionError': '连接错误'

}.get(error_type, '未知错误')

|

实际应用案例

以下是一个实际的 MCP 服务示例,用于处理 AI 模型的调用:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

| @mcp.tool()

async def invoke_ai_model(model_type: str, prompt: str) -> str:

"""调用指定的 AI 模型"""

try:

response = await ai_model_manager.invoke(

model_type=model_type,

prompt=prompt

)

return response

except Exception as e:

return f"模型调用错误:{str(e)}"

@mcp.tool()

async def get_model_status(model_type: str) -> str:

"""获取模型状态"""

return await ai_model_manager.get_status(model_type)

|

最佳实践

异步处理

- 使用 async/await 处理并发请求

- 实现请求队列管理

- 添加超时机制

错误处理

- 实现统一的错误处理机制

- 详细的错误日志记录

- 优雅的错误恢复策略

性能优化

安全性

部署和监控

本地开发环境:

1

2

3

| python -m mcp_service

uvicorn mcp_service:app --host 0.0.0.0 --port 8080

|

生产环境部署:

总结

MCP 服务为 AI 模型的调用提供了一个标准化的解决方案。通过实现 Model Context Protocol,我们可以:

- 统一管理多个 AI 模型

- 提供标准化的调用接口

- 实现灵活的扩展机制

- 确保服务的可靠性和可维护性

通过本文的实践指南,你应该能够构建出一个专业的 MCP 服务,为你的 AI 应用提供可靠的模型调用支持。

参考资源

本文由作者梳理思路,并由 Cursor AI 辅助生成。如有任何问题或建议,欢迎与作者交流。