实用的python

目标有了,现在就是找资源了。根据我看的爬虫都是从某个网站爬,解析里面的内容,这和需求有出入啊,我要是都知道了网站,我还爬毛线啊,那可不可以通过这个网站的内部链接一直爬下去呢,比如拿到一个链接打开,解析看有没有关键字,有说明可用,保存,再爬下一个,让爬一千次吧。想想还可行,开始搞,写到解析关键字这里google半天,跑起来~ 卡死了,网页内容太多。所以正常的程序员思维估计要解决这个问题会想半天,我就是写个演示程序,要是不能在30分钟内搞出来,怎么体现实用性,当你想那啥,调整好状态了,你却要先写几个钟代码才能找到资源,这不是扯么,所以我决定换个思路,既然不能解析,那能不能找找资源的规律,还真有,这种网站都是数字加字母的。啊~ 瞬间就明朗了起来,那我爬这种格式的资源再检索应该没问题,所以简单写了个random网址,加上筛选,搞定~

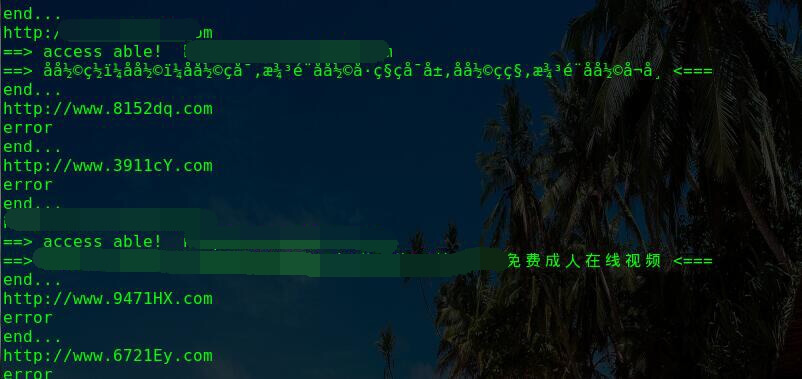

测试:

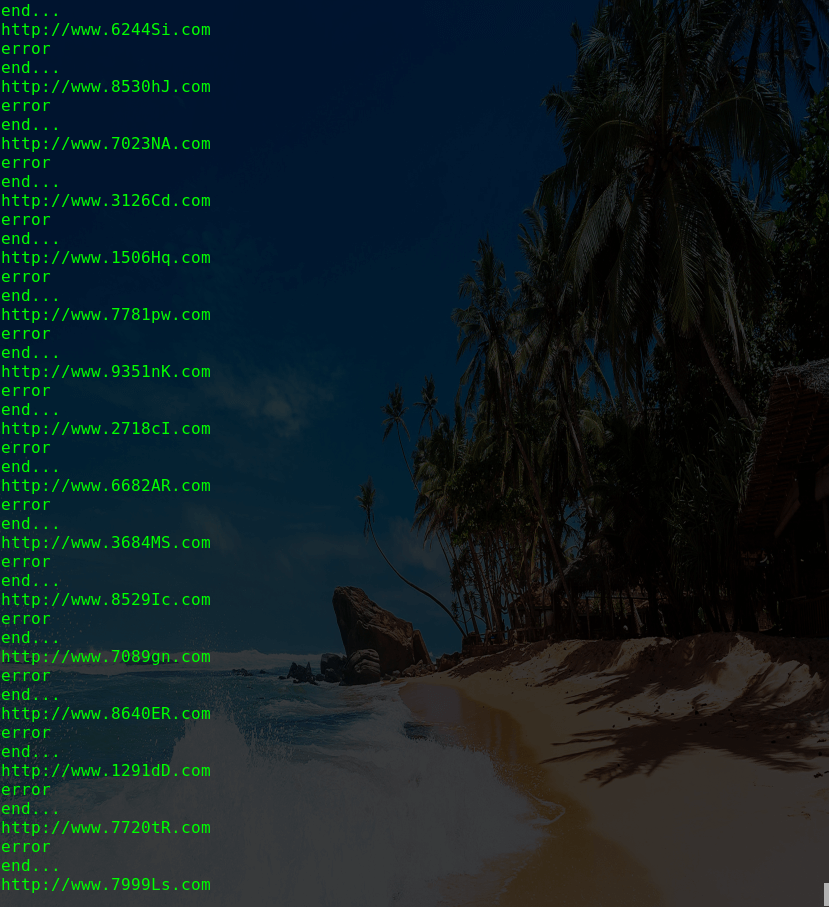

这么看起来还ok,赶紧让他试试,他的实际效果是:

所以你看,虽然我们的理论看起来正确,也很科学,但~ 并没有什么卵用。

end